LLM(大規模言語モデル)のパラメータとは?仕組み・学習・入力から出力まで

大規模言語モデル(LLM)のパラメータとは何か、学習方法や入力から出力までの流れをエンジニア向けにわかりやすく解説します。

はじめに

ChatGPTをはじめとする大規模言語モデル(LLM)が一般にも普及し、注目を集めています。

この記事では、エンジニア向けに「LLMのパラメータとは何か」「パラメータはどう学習されるのか」「入力から出力までどんな処理が行われるのか」を体系的にまとめました。

内部動作を正しく理解するための基礎として、ぜひ参考にしてください。

パラメータとは何か?

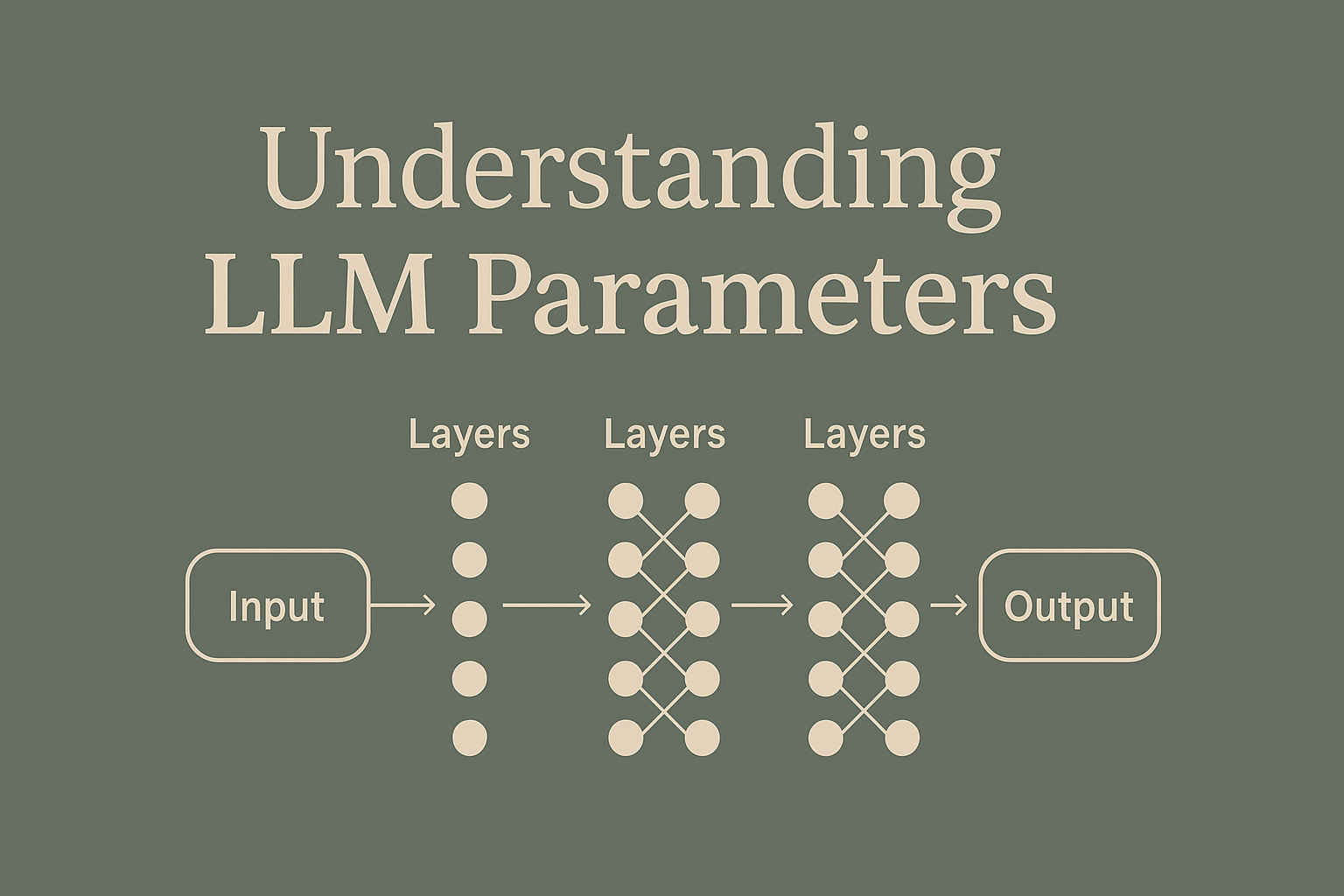

LLMにおけるパラメータとは、モデル内部に存在する**ノード間をつなぐ「重み」や「バイアス」**を指します。

単なるノードの数ではなく、**ノード同士を結ぶ線(重み)**の数がパラメータ数になります。

具体例:

- 入力ノード100個

- 中間層ノード200個

この場合、入力と中間層間だけで100×200=20,000個のパラメータが存在する計算です。

これに後続の層を加えると、最終的なパラメータ数は数百億〜数兆単位に及びます。

パラメータ数が多いと何が変わるのか?

パラメータ数が増えると、モデルの表現力が向上します。

たとえば、

- より複雑な文脈を理解できる

- 多様な応答ができる

- ニッチな知識にも対応できる

といった効果が得られます。

一方で、

- 計算リソース消費の増大

- 推論・学習時間の増加

といったデメリットもあるため、近年では「小型化しつつ高性能なモデル」を目指す研究も盛んです。

パラメータはどう学習されるのか?

パラメータ学習の流れは、ざっくり次の通りです。

- 入力に対して予測を行う

- 正解と比較し誤差(ロス)を計算する

- ロスに基づいてパラメータを微調整する

この繰り返しにより、モデルは少しずつ精度を上げていきます。

主要な技術としては、

- ロス関数(誤差の定義)

- 最適化手法(オプティマイザ)

- 勾配降下法(Gradient Descent)

などが使われます。

入力から出力までの流れ

LLMでは、ユーザーの入力がモデルに届いてから出力が返されるまでに、次のような処理が行われます。

①トークン化 → ベクトル化

まず、文章(自然言語)は**トークン化(Tokenization)**されます。

たとえば、「私は猫が好き」という入力は

["私", "は", "猫", "が", "好き"]

といった単位に分割されます。

続いて、それぞれのトークンは、**ベクトル(数値列)に変換されます。

これがベクトル化(Embedding)**です。

例)

- 「猫」→

[0.75, -0.34, 0.22, ...]

トークン化とベクトル化により、自然言語はモデルが計算可能な数値データに変換されます。

②層(レイヤー)を順番に通過する

ベクトル化された入力は、モデル内部の層を順番に通過して処理されます。

- 1層目:入力ベクトルに対する変換

- 2層目:1層目の出力をさらに処理

- ...

- 最終層:出力(たとえば次のトークン)を決定

この過程で、パラメータ(重み・バイアス)が随所で適用され、

入力情報が徐々に変換・圧縮・抽象化されていきます。

結果として、モデルは適切な出力を生成します。

まとめ

LLMのパラメータとは、モデルが入力を理解・変換するための知識のかたまりです。

その数と品質が、モデルの性能を大きく左右します。

また、入力から出力に至るまでには

- トークン化

- ベクトル化

- 層を順番に通過するプロセス

がしっかり設計されており、パラメータを活用した大量の数値計算が裏で行われています。

本記事が、LLM内部の理解の一助になれば幸いです。

通りすがりのラマ🦙

このブログでは個人開発で得た知見や興味のあるテクノロジーに関する記事を執筆します。 日々公開されている情報に助けられているので、自分が得た知見も世の中に還元していければと思います。 解決できないバグに出会うと、草を食べます。🦙🌿 経歴: 情報工学部→日系SIer→外資系IT企業 興味: Webアプリケーション開発、Webデザイン、AI 趣味: 個人開発、テニス