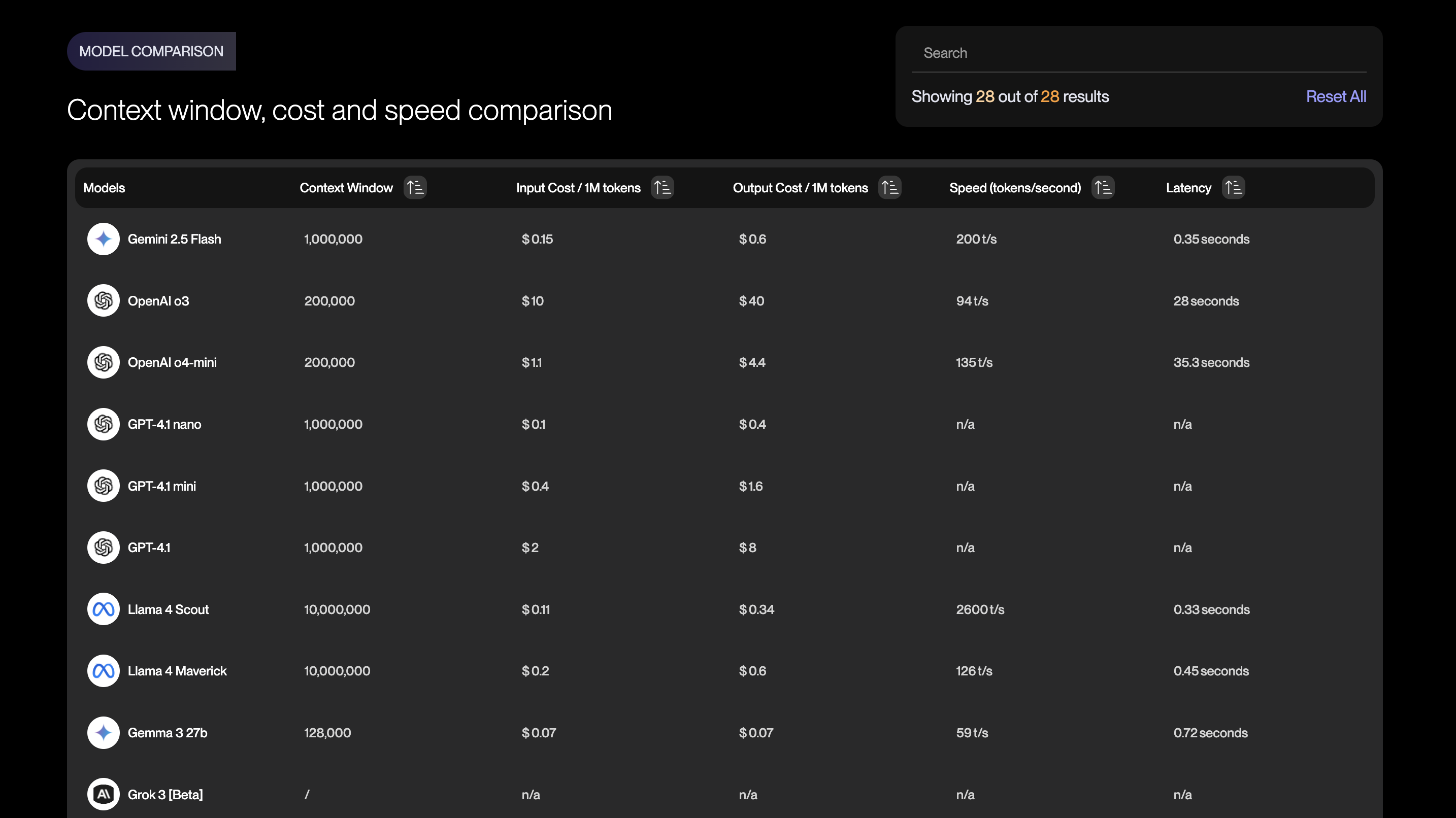

モデル比較に有用なvellumのLLMリーダーボードとは

大規模言語モデル(LLM)の選定に役立つ「vellum LLMリーダーボード」の特徴を紹介。性能・コスト・実用性を比較できる優れたツールです。

はじめに

大規模言語モデル(LLM)が次々登場する今、

**「どのモデルを使うべきか」**で悩む開発者やプロダクトマネージャーも多いのではないでしょうか。

そんなときに役立つのが、vellum.aiのLLMリーダーボードです。

この記事では、モデル比較に強い理由を中心に、便利なポイントを簡単に紹介します。

なぜ「モデル比較」が重要なのか?

モデル選びを間違えると、

- 思ったよりコストが高くつく

- 入力できる情報量が足りない

- タスクに対して性能が不足している

といった問題が起こりがちです。

性能スコアだけでなく、実運用を見据えた比較ができることが非常に重要です。

vellum LLMリーダーボードの特長

1. コンテキストウィンドウの比較ができる

各モデルの最大コンテキスト長(許容トークン数)が一覧で確認できます。

大量のデータや長文を扱うケースでは、非常に重要な指標です。

2. APIコストがすぐわかる

モデルごとの1MトークンあたりのAPIコストが一目で分かります。

開発段階だけでなく、リリース後の運用コスト見積もりにも役立ちます。

3. 性能スコアだけじゃない

一般的なベンチマーク(MMLU、GSM8Kなど)のスコアも網羅されていますが、

単なる「点数勝負」ではなく、実用性重視でモデル選定ができる点が大きな魅力です。

まとめ

vellumのLLMリーダーボードは、

「性能」「コンテキスト長」「コスト」など、実務に直結する比較軸でモデルを選べる、非常に実用的なツールです。

LLM選びに悩んでいるなら、ぜひ一度チェックしてみてください!

通りすがりのラマ🦙

このブログでは個人開発で得た知見や興味のあるテクノロジーに関する記事を執筆します。 日々公開されている情報に助けられているので、自分が得た知見も世の中に還元していければと思います。 解決できないバグに出会うと、草を食べます。🦙🌿 経歴: 情報工学部→日系SIer→外資系IT企業 興味: Webアプリケーション開発、Webデザイン、AI 趣味: 個人開発、テニス